Robots.txt

Definícia

Súbor robots.txt informuje robotov vyhľadávacieho nástroja (napr. Googlebot) a crawl programy (napr. Streaming Frog) o tom, ktoré webové stránky alebo súbory prehľadávač môže alebo nemôže prechádzať.

Popis

Súbor robots.txt je súčasťou protokolu o vylúčení robotov (REP), skupiny webových štandardov, ktoré regulujú, ako roboty prehľadávajú web, pristupujú k obsahu, indexujú ho a poskytujú tento obsah používateľom. REP tiež obsahuje smernice, ako sú meta roboty, ako aj pokyny pre celú stránku, podadresár alebo lokalitu, ako by mali vyhľadávacie nástroje zaobchádzať s odkazmi (napríklad „follow“ alebo „nofollow“).

V praxi súbory robots.txt indikujú, či určití používateľskí agenti (softvér na prehľadávanie webu) môžu alebo nemôžu prehľadávať časti webovej lokality. Tieto pokyny na prehľadávanie sú špecifikované zakázaním alebo povolením správania určitých (alebo všetkých) používateľských agentov.

Ako funguje súbor robots.txt?

Pri prehľadávaní stránok vyhľadávače sledujú odkazy, aby sa dostali z jednej stránky na druhú – v konečnom dôsledku prehľadávajú mnoho miliárd odkazov a webových stránok. Toto správanie pri indexovom prehľadávaní je niekedy známe ako „pavúk“.

Po príchode na webovú stránku, ale pred jej „spidering”, vyhľadávací prehľadávač vyhľadá súbor robots.txt. Ak nejaký nájde, prehľadávač najprv prečíta tento súbor a až potom bude pokračovať cez stránku. Pretože súbor robots.txt obsahuje informácie o tom, ako by mal vyhľadávací nástroj prehľadávať, informácie, ktoré sa v ňom nachádzajú, povedú k ďalšej činnosti prehľadávača na tejto konkrétnej lokalite.

Ak súbor robots.txt neobsahuje žiadne príkazy, ktoré zakazujú činnosť používateľského agenta (alebo ak stránka nemá súbor robots.txt), bude pokračovať v prehľadávaní ďalších informácií na stránke.

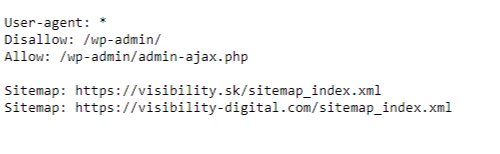

Príklad

Ukážka zápisu robots.txt na stránke visibility.sk